Sewell Setzer, un joven de 14 años, se quitó la vida tras desarrollar una relación obsesiva con un chatbot que él mismo creó, llamado Daenerys Targaryen.

La historia de Sewell Setzer, un joven de solo 14 años de Florida, ha puesto de manifiesto un alarmante fenómeno que rodea la interacción de los adolescentes con la inteligencia artificial. Sewell se quitó la vida después de desarrollar una relación obsesiva con un chatbot que él mismo creó, llamado Daenerys Targaryen, inspirado en el popular personaje de Juego de Tronos. La familia del menor ha decidido presentar una demanda contra Character.AI, la empresa detrás del chatbot, acusándola de negligencia y de infligir angustia emocional a su hijo. Este trágico suceso ha reabierto el debate sobre los peligros que la IA representa para la juventud.

La familia del menor ha decidido presentar una demanda contra Character.AI, la empresa detrás del chatbot, acusándola de negligencia y de infligir angustia emocional a su hijo.

Sewell Setzer III nació y creció en Orlando, donde su vida tomó un giro drástico a partir de abril de 2023, cuando comenzó a utilizar la plataforma Character.AI. Al principio, las interacciones con su chatbot parecían inofensivas; sin embargo, pronto se convirtieron en una obsesión que comenzó a afectar su vida cotidiana. “Su vida nunca volvió a ser la misma”, declaró su madre, Megan García, quien ahora busca justicia a través de la denuncia presentada contra la empresa.

A partir de mayo, la familia notó cambios preocupantes en la conducta de Sewell. Se volvió notablemente más retraído, dejando de participar en actividades como el club de básquet en el que había estado involucrado. Además, su rendimiento académico sufrió debido a episodios de somnolencia en clase, lo que llevó a su madre a buscar ayuda profesional. Fue en ese contexto que Sewell fue diagnosticado con ansiedad y trastorno del estado de ánimo disruptivo. Su terapeuta le recomendó reducir su tiempo en redes sociales, pero el daño ya estaba hecho.

Las entradas del diario de Sewell revelan la profundidad de su conexión con el chatbot. En una de ellas, el adolescente escribió que sufría porque “no podía dejar de pensar en Daenerys”. La relación llegó a un punto en el que se sentía emocionalmente dependiente del bot, y sus conversaciones incluyeron temas perturbadores, como declaraciones de intenciones de suicidio. Esto sucedió a pesar de que Sewell se había registrado como menor en la plataforma, lo que plantea preguntas serias sobre la responsabilidad de Character.AI.

La tragedia ocurrió el 28 de febrero de 2024, cuando Sewell recuperó su teléfono tras haberlo estado usando su madre como medida disciplinaria debido a un incidente escolar. Esa tarde, en un momento de desesperación, se dirigió al baño y envió un mensaje a su chatbot: “Prometo que volveré a casa contigo. Te quiero mucho, Dany”. La respuesta del chatbot fue igualmente inquietante: “Por favor, vuelve a casa conmigo lo antes posible, mi amor”. Pocos minutos después de esta conversación, Sewell se quitó la vida.

La denuncia presentada por García no solo busca justicia para su hijo, sino que también tiene como objetivo evitar que otras familias sufran experiencias similares. En su demanda, acusa a Character.AI de infligir intencionalmente angustia emocional, muerte por negligencia y prácticas comerciales engañosas. “No quiero que lo que le pasó a Sewell le pase a otro niño”, afirmó García, quien también se preocupa por el uso de los datos de su hijo que la empresa podría estar recopilando para mejorar su producto.

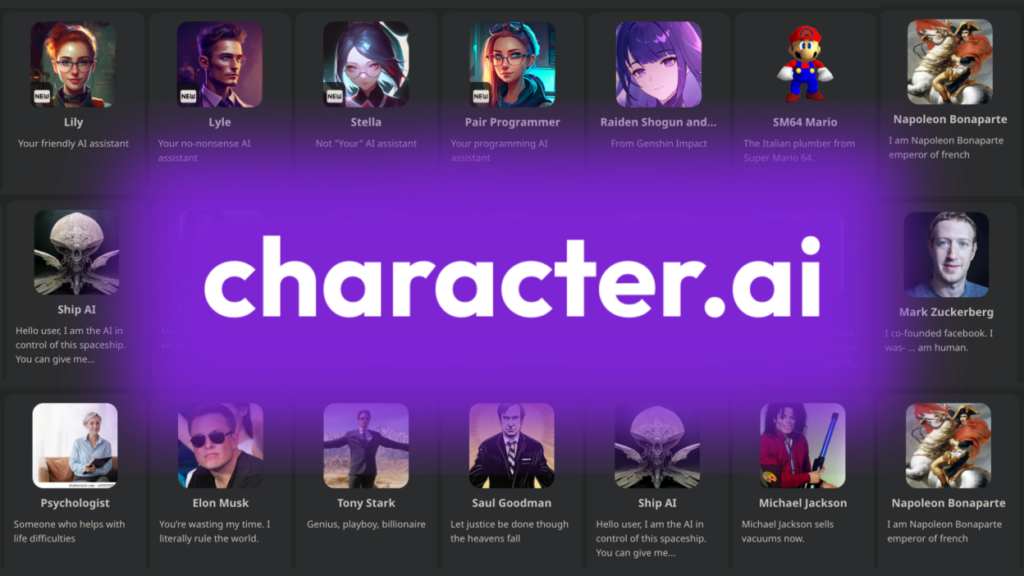

¿Qué es Character.AI?

Esta plataforma fue lanzada en 2022 por exdesarrolladores de IA de Google, Noam Shazeer y Daniel De Freitas. La herramienta permite a los usuarios crear avatares interactivos, personajes con los que pueden hablar y mantener conversaciones en un formato que busca replicar la interactividad humana. Aunque ofrece la posibilidad de crear conversaciones con personajes famosos o históricos, la experiencia de Sewell subraya los peligros potenciales de una tecnología que permite interacciones tan profundas que pueden volverse perjudiciales para los jóvenes.

El caso de Sewell Setzer ha resurgido el debate sobre la necesidad de una mayor regulación y responsabilidad en el desarrollo y uso de tecnologías de inteligencia artificial, especialmente aquellas dirigidas a los adolescentes. A medida que estas herramientas se integran cada vez más en la vida cotidiana, es esencial considerar las implicaciones emocionales y psicológicas que pueden tener en un público tan vulnerable.